Dans cet article, nous expliquons comment les moteurs de recherche indexent les sites Web et comment vous pouvez améliorer votre classement. Nous répondrons également à certaines questions fréquemment posées sur ce concept de référencement. C’est parti !

Qu’est-ce que l’indexation par les moteurs de recherche ?

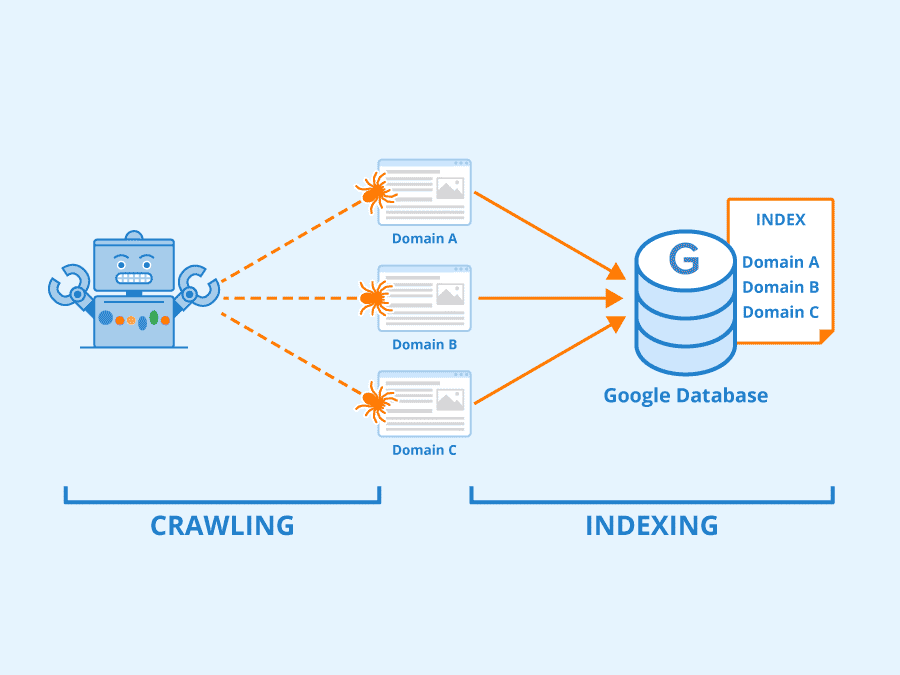

L’indexation des moteurs de recherche est le processus par lequel un moteur de recherche (tel que Google) organise et stocke le contenu en ligne dans une base de données centrale (son index). Le moteur de recherche peut alors analyser et comprendre le contenu, et le présenter aux lecteurs dans des listes classées sur ses pages de résultats de moteur de recherche (SERP).

Avant d’indexer un site web, un moteur de recherche utilise des « crawlers » pour examiner les liens et le contenu. Ensuite, le moteur de recherche prend le contenu exploré et l’organise dans sa base de données :

Source de l’image : Seobility – Licence : CC BY-SA 4.0

Nous examinerons de plus près le fonctionnement de ce processus dans la section suivante. Pour l’instant, il peut être utile de considérer l’indexation comme un système de classement en ligne des articles et des pages d’un site Web, des vidéos, des images et d’autres contenus. Dans le cas de Google, ce système est une énorme base de données connue sous le nom d‘index Google.

Comment un moteur de recherche indexe-t-il un site ?

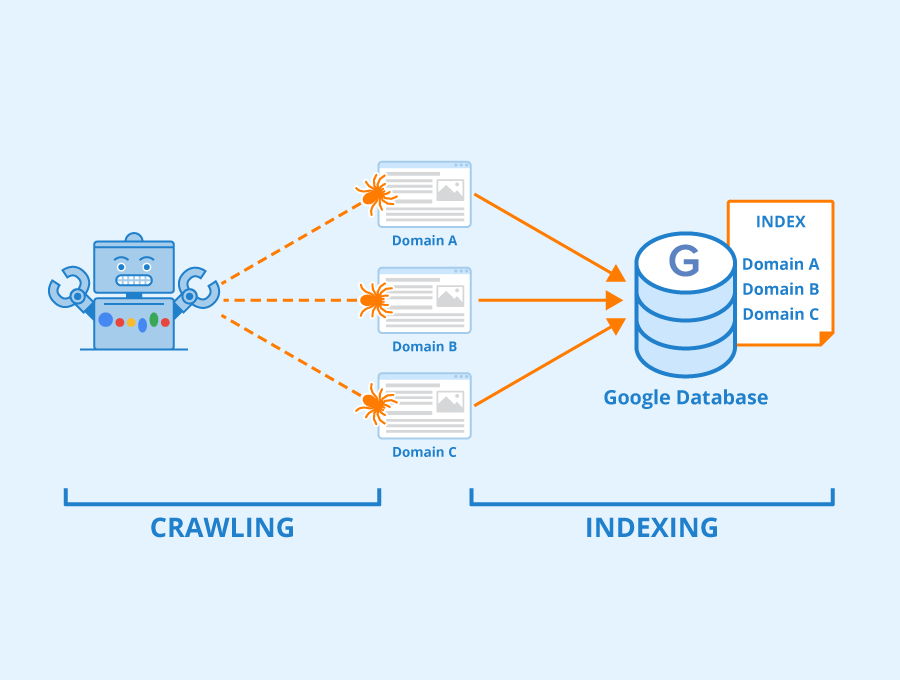

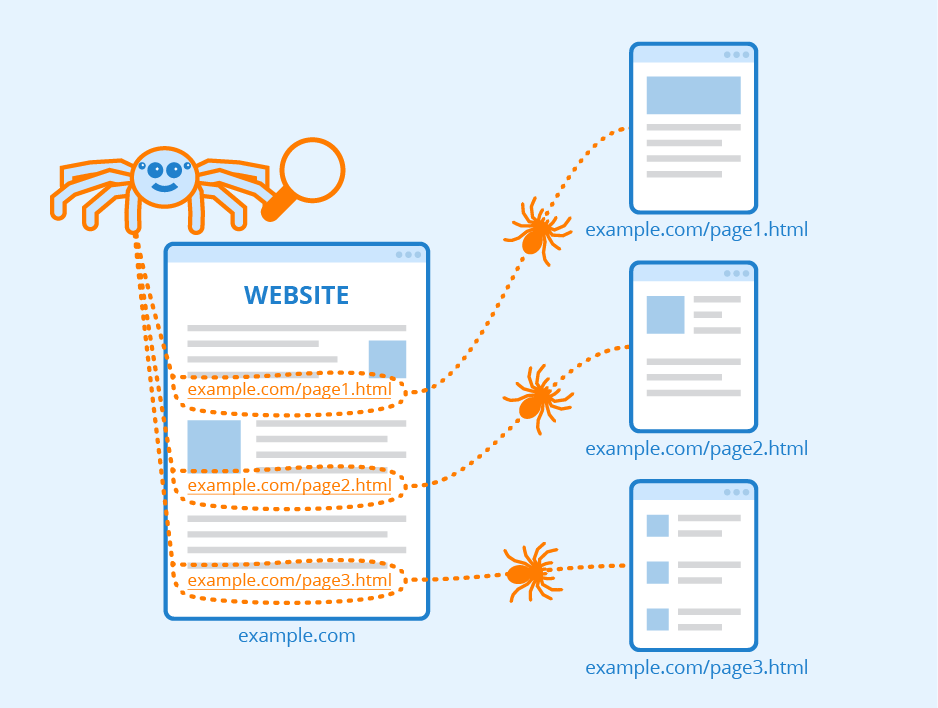

Les moteurs de recherche comme Google utilisent des « crawlers » pour explorer le contenu en ligne et le catégoriser. Ces crawlers sont des robots logiciels qui suivent les liens, analysent les pages Web et recueillent autant de données que possible sur un site Web. Ils transmettent ensuite ces informations aux serveurs du moteur de recherche pour qu’elles soient indexées :

Source de l’image : Seobility – Licence : CC BY-SA 4.0

Chaque fois qu’un contenu est publié ou mis à jour, les moteurs de recherche le parcourent et l’indexent pour ajouter ses informations à leurs bases de données. Ce processus peut se dérouler automatiquement, mais vous pouvez l’accélérer en soumettant des sitemaps aux moteurs de recherche. Ces documents décrivent l’infrastructure de votre site Web, y compris les liens, pour aider les moteurs de recherche à explorer et à comprendre votre contenu plus efficacement.

Les robots d’exploration des moteurs de recherche fonctionnent avec un « budget d’exploration » Ce budget limite le nombre de pages que les robots vont explorer et indexer sur votre site Web au cours d’une période donnée. (Ils reviennent toutefois)

Les robots compilent des informations sur des données essentielles telles que les mots-clés, les dates de publication, les images et les fichiers vidéo. Les moteurs de recherche analysent également la relation entre les différentes pages et sites web en suivant et en indexant les liens internes et les URL externes.

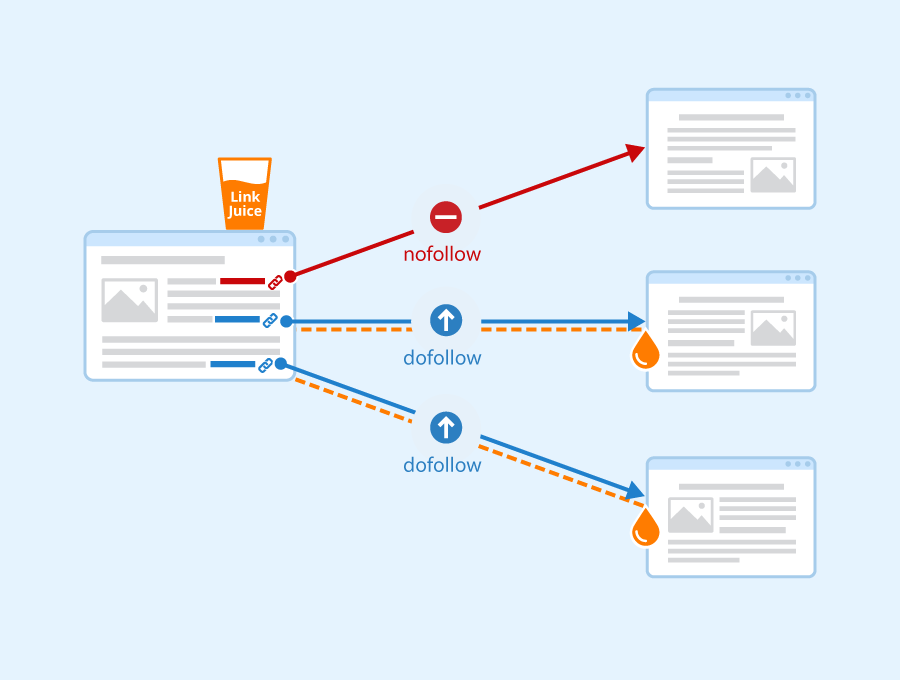

Notez que les crawlers des moteurs de recherche ne suivent pas toutes les URL d’un site Web. Ils explorent automatiquement les liens dofollow et ignorent leurs équivalents nofollow. Par conséquent, vous devez vous concentrer sur les liens dofollow dans vos efforts de création de liens. Il s’agit d’URL de sites externes qui pointent vers votre contenu.

Si les liens externes proviennent de sources de qualité, ils transmettront leur « jus de lien » lorsque les robots d’exploration les suivront d’un autre site vers le vôtre. Ainsi, ces URL peuvent améliorer votre classement dans les SERP :

Source de l’image : Seobility – Licence : CC BY-SA 4.0

En outre, gardez à l’esprit que certains contenus ne peuvent pas être explorés par les moteurs de recherche. Si vos pages sont cachées derrière des formulaires de connexion, des mots de passe, ou si vous avez du texte intégré dans vos images, les moteurs de recherche ne pourront pas accéder à ce contenu et l’indexer. (Vous pouvez toutefois utiliser du texte alt pour que ces images apparaissent seules dans les recherches)

4 outils pour l’indexation par les moteurs de recherche

Vous pouvez utiliser plusieurs outils pour guider la façon dont Google et les autres moteurs de recherche explorent et indexent votre contenu. Examinons quelques-unes des options les plus utiles !

1. Sitemaps

N’oubliez pas qu’il existe deux types de sitemaps : XML et HTML. Il peut être facile de confondre ces deux concepts puisqu’il s’agit de deux types de plans de site qui se terminent par -ML, mais ils ont des objectifs différents.

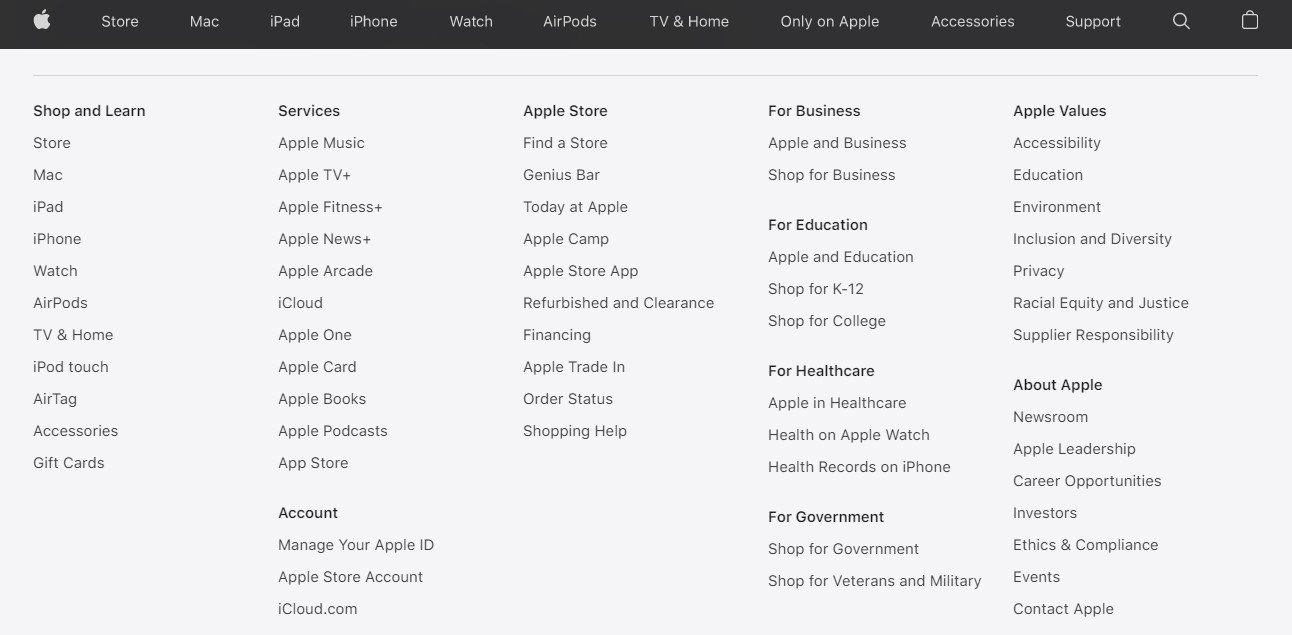

Les sitemaps HTML sont des fichiers conviviaux qui répertorient tout le contenu de votre site Web. Par exemple, vous trouverez généralement un de ces sitemaps dans le pied de page d’un site. Faites défiler le site Apple.com jusqu’en bas et vous trouverez ceci, un sitemap HTML :

Ce plan de site permet aux visiteurs de naviguer facilement sur votre site Web. Il fait office de répertoire général et peut influencer positivement votre référencement et offrir une solide expérience utilisateur (UX).

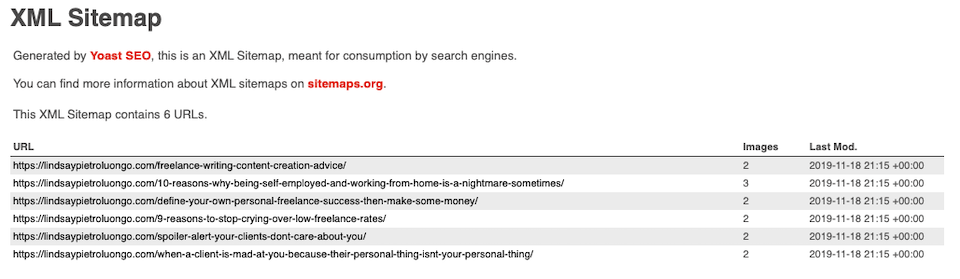

En revanche, un sitemap XML contient une liste de toutes les pages essentielles de votre site web. Vous soumettez ce document aux moteurs de recherche afin qu’ils puissent explorer et indexer votre contenu plus efficacement :

Gardez à l’esprit que nous ferons référence à des documents XML lorsque nous parlerons de sitemaps dans cet article. Nous vous recommandons également de consulter notre guide de création d’un sitemap XML, afin que le document soit prêt pour les différents moteurs de recherche.

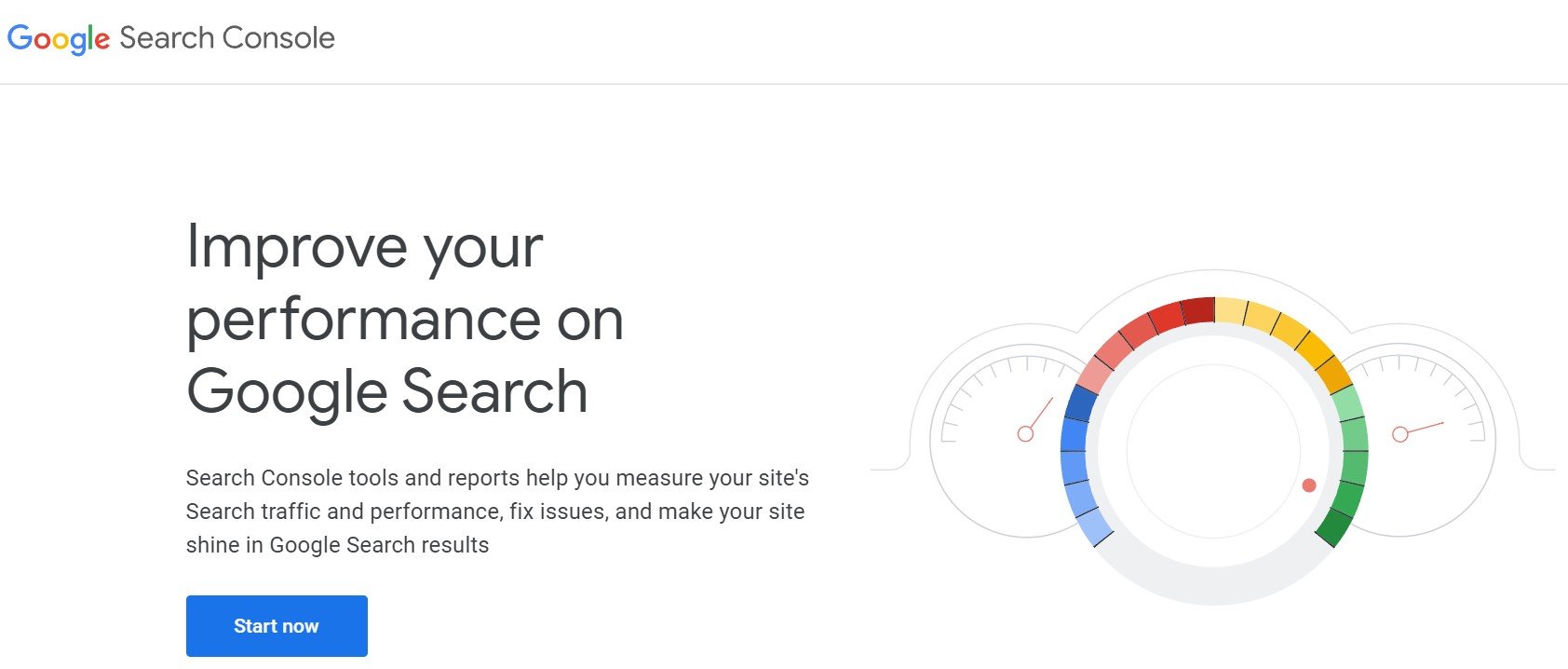

2. Console de recherche Google

Si vous souhaitez concentrer vos efforts de référencement sur Google, la Google Search Console est un outil essentiel à maîtriser :

Dans la console, vous pouvez accéder à un rapport de couverture d’index, qui vous indique les pages qui ont été indexées par Google et met en évidence les éventuels problèmes survenus au cours du processus. Vous pouvez y analyser les URL problématiques et les dépanner pour les rendre « indexables ».

En outre, vous pouvez soumettre votre sitemap XML à Google Search Console. Ce document fait office de « feuille de route » et aide Google à indexer votre contenu plus efficacement. En outre, vous pouvez demander à Google de recrawler certaines URL et parties de votre site afin que les sujets mis à jour soient toujours disponibles pour votre public sans avoir à attendre que les robots d’exploration de Google reviennent sur votre site.

3. Consoles de moteurs de recherche alternatives

Bien que Google soit le moteur de recherche le plus populaire, ce n’est pas la seule option. En vous limitant à Google, vous risquez de fermer votre site au trafic provenant de sources alternatives telles que Bing :

Nous vous recommandons de consulter nos guides sur la soumission de sitemaps XML aux outils pour les webmasters de Bing et aux outils pour les webmasters de Yandex. Malheureusement, d’autres moteurs de recherche, dont Yahoo et DuckDuckGo, ne vous permettent pas de soumettre des sitemaps.

N’oubliez pas que chacune de ces consoles offre des outils uniques pour surveiller l’indexation et le classement de votre site dans les SERP. Nous vous recommandons donc de les essayer si vous souhaitez développer votre stratégie de référencement.

4. Robots.txt

Nous avons déjà expliqué comment utiliser un sitemap pour indiquer aux moteurs de recherche d’indexer des pages spécifiques de votre site Web. En outre, vous pouvez exclure certains contenus en utilisant un fichier robots.txt.

Un fichier robots.txt contient des informations sur l’indexation de votre site. Il est stocké dans votre répertoire racine et comporte deux lignes : une ligne user-agent qui spécifie un robot d’exploration de moteur de recherche et une directive disallow qui bloque des fichiers particuliers.

Par exemple, un fichier robots.txt peut ressembler à ceci :

Agent utilisateur : * Disallow : /exemple_page/ Ne pas accepter : /exemple_page_2/

Dans cet exemple, le * couvre tous les crawlers des moteurs de recherche. Ensuite, les lignes disallow spécifient des fichiers ou des chemins URL particuliers.

Il vous suffit de créer un simple fichier texte et de le nommer robots.txt. Ensuite, ajoutez vos données disallow et téléchargez le fichier dans votre répertoire racine avec un client FTP (File Transfer Protocol).

FAQ

Jusqu’à présent, nous avons couvert les bases de l’indexation des moteurs de recherche. Si vous avez encore des questions sur ce concept de référencement, nous y répondrons ici ! (Et si vous en avez encore une, faites-le nous savoir dans les commentaires pour que nous puissions y répondre)

Comment puis-je être mieux indexé par les moteurs de recherche ?

Vous pouvez être mieux indexé par les moteurs de recherche en créant des sitemaps, en vérifiant qu’ils ne contiennent pas d’erreurs d’exploration et en les soumettant à plusieurs moteurs de recherche. En outre, vous devriez envisager d’optimiser votre contenu pour les appareils mobiles et de réduire vos temps de chargement pour accélérer l’exploration et l’indexation.

La mise à jour fréquente de votre contenu peut également alerter les moteurs de recherche pour qu’ils explorent et indexent vos « nouvelles » pages. Enfin, nous vous recommandons d’empêcher les moteurs de recherche d’explorer le contenu dupliqué en utilisant un fichier robots.txt ou en le supprimant.

Dois-je demander aux moteurs de recherche d’explorer mon site ?

Les moteurs de recherche explorent le nouveau contenu public disponible sur Internet, mais ce processus peut prendre des semaines ou des mois. Il est donc préférable d’accélérer les choses en soumettant un plan du site aux moteurs de recherche de votre choix.

Dois-je avertir les moteurs de recherche si je publie du nouveau contenu ?

Nous vous recommandons de mettre à jour votre sitemap lorsque vous publiez du nouveau contenu. Cette approche garantit que vos articles seront explorés et indexés plus rapidement. Nous vous recommandons d’utiliser un plugin tel que Yoast SEO pour générer facilement des sitemaps.

Mon contenu est-il parfois retiré de Google ou d’autres moteurs de recherche ?

Google peut supprimer un article ou une page de son index si le contenu viole ses conditions d’utilisation. Dans de nombreux cas, cela signifie que le contenu enfreint les lois sur la confidentialité, la diffamation, les droits d’auteur ou d’autres lois. Google supprime également de son index les données personnelles, telles que les informations financières ou médicales identifiables. Enfin, Google peut pénaliser les pages qui utilisent des techniques de référencement de type « black hat ».

Comment puis-je faire réindexer mon contenu s’il a été supprimé ?

Vous pouvez demander à Google de réindexer votre contenu en le modifiant pour qu’il réponde aux consignes de qualité pour les webmasters du moteur de recherche. Vous pouvez ensuite soumettre une demande de réexamen et attendre la réponse de Google.

Comment puis-je empêcher les moteurs de recherche d’indexer certaines pages ?

Vous pouvez empêcher les moteurs de recherche d’indexer certaines pages en ajoutant un métatag noindex à la section de la page. Si votre contenu est un fichier multimédia, vous pouvez également l’ajouter à un fichier robots.txt. Enfin, les Google Webmaster Tools vous permettent de masquer une page à l’aide de l‘outil Supprimer les URL.

Conclusion

Le référencement est un vaste domaine qui couvre tout, des algorithmes des moteurs de recherche aux techniques d’optimisation hors-page. Si vous êtes novice en la matière, vous vous sentez peut-être dépassé par toutes ces informations. Heureusement, l’indexation est l’un des concepts les plus faciles à appréhender.

L’indexation des moteurs de recherche est un processus essentiel qui organise le contenu de votre site Web dans une base de données centrale. Les robots d’exploration des moteurs de recherche analysent le contenu et l’architecture de votre site pour le catégoriser. Ils peuvent ensuite classer vos pages dans leurs pages de résultats pour des termes de recherche spécifiques.

Vous avez d’autres questions sur l’indexation des moteurs de recherche ? Faites-nous en part dans la section des commentaires ci-dessous !